Für die automatisierte Analyse geometrischer Messdaten nutzen wir künstliche neuronale Netze (KNN), die wir für den jeweiligen Anwendungsfall mithilfe eigener Trainingsdaten trainieren. Wir verfügen über einen großen Satz an 2D- und 3D-Daten, auf die wir bei der Erstellung von Trainings- und Testdaten zurückgreifen können. Dies erlaubt es uns, Objektklassen und Datensätze auf die jeweilige Problemstellung anzupassen. So erzielen wir bessere Analyse-Ergebnisse, als es mit öffentlich zugänglichen Datensätzen möglich ist.

Gute Trainingsdaten – erfolgreiche Datenanalyse

Künstliche neuronale Netze können nur so gut sein, wie die Daten, mit denen sie trainiert wurden. Daher haben wir Strukturen und Best Practices entwickelt, die das Beste aus unseren Daten herausholen: Die Vorbereitung zum Training eines Netzes / Modells umfasst vier Punkte:

- Klassendefinition

- Datenauswahl

- Annotierung

- Evaluierung

Maßgeblich für das Design des Trainingsprozesses sind die spezifischen Fragestellungen unserer Kunden und Forschungspartner bezüglich der Datenanalyse. Für das Training künstlicher neuronaler Netze bedeutet das: Wir legen eine Liste an Objektklassen an, die für die geforderte Datenanalyse relevant sind. Diese Objektklassenliste definiert, welche Daten relevant sind und wie diese annotiert werden. Unser Team erarbeitet diese Klassen in gemeinsamen Workshops, um die effizienteste Ausgabe zu erzeugen.

Sorgfältige Datenauswahl und pixel- bzw. punktgenaue Annotierung: Qualität der Daten bestimmt Zuverlässigkeit des Modells

Im nächsten Schritt werden die passenden Daten ausgewählt. Die Endanwendung gibt die Anforderungen an die Robustheit der Erkennung vor. Ein System das beispielsweise ganzjährig im Außenbereich funktionieren soll, braucht Trainingsdaten der gleichen oder einer vergleichbaren Sensorik, die die sich ändernden Umgebungsbedingungen über das gesamte Jahr beinhalten. Die Mindestanzahl von Beispielen der am seltensten vorkommenden Klasse definiert die Gesamtmenge des benötigten Datensatzes, da die nötige Varianz und die natürliche Verteilung der Klassen berücksichtigt werden müssen.

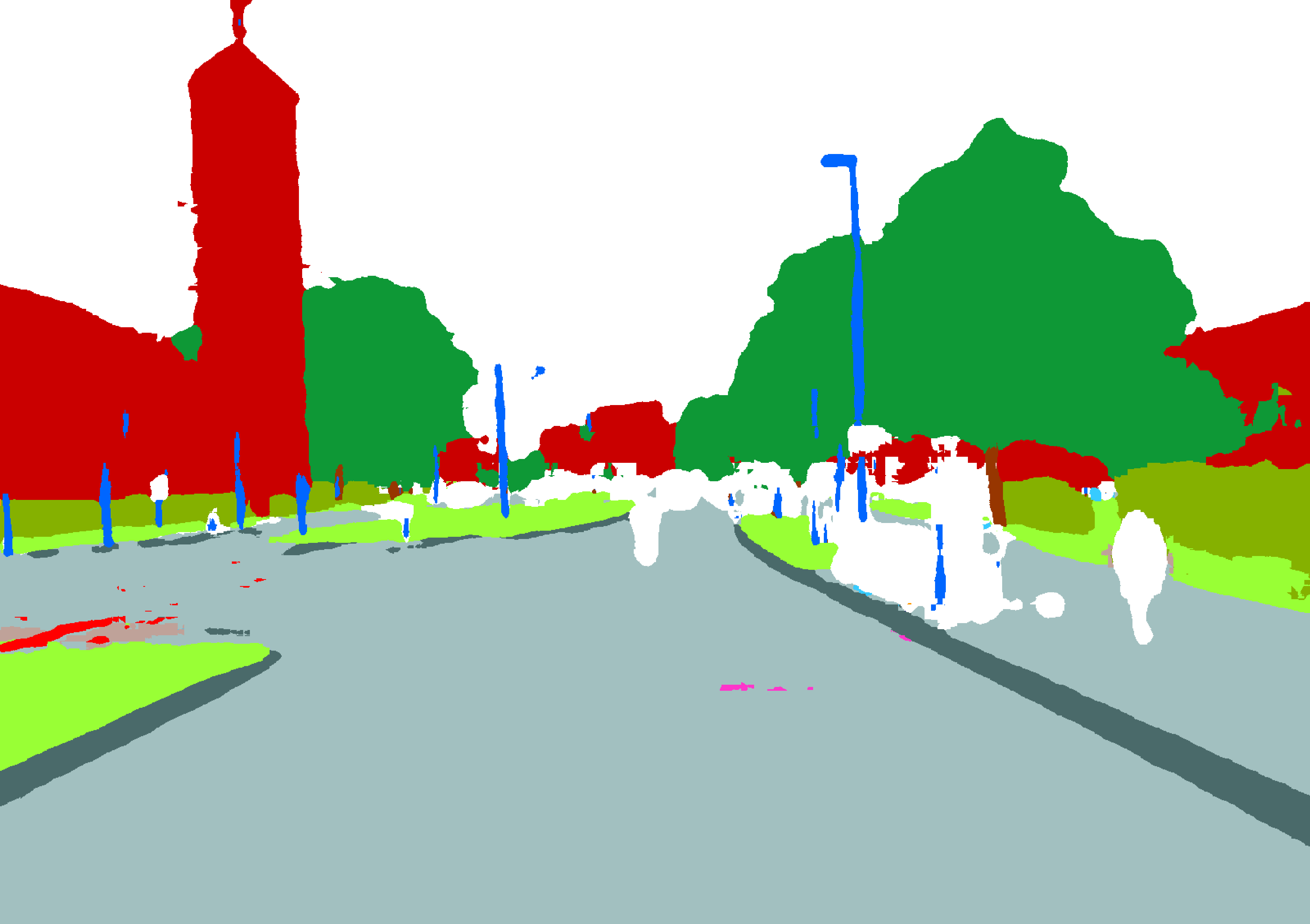

Die ausgewählten Daten werden dann schließlich händisch annotiert, d.h. semantisch gekennzeichnet. Hier wird das »Bilderbuch« erstellt, mithilfe dessen das Netz trainiert wird bzw. lernen kann. Dieser aufwändige Prozess ist bislang Stand der Technik, da die Qualität der Trainingsdaten das Ergebnis des Modells bestimmt. Sowohl bei Bildern als auch bei Punktwolken aus Laserscannern werden die Objekte entsprechend der Klassenliste pixel-/punktgenau ausgewählt und einer Objektklasse und ggfs. einer Instanz dieser Klasse zugeteilt. Für einen effizienten Workflow und die nötige Qualitätskontrolle haben wir ebenfalls Best Practices erprobt und wenden diese an.

Ein Teil der so gewonnen Daten bildet die Grundlage der Evaluierung unserer Netze, der sogenannten »Groundtruth«. Mit den Testdaten lassen sich die Genauigkeiten der Klassen in der Erkennung testen und ggfs. Stellschrauben identifizieren, mit denen das Ergebnis verbessert werden kann.

Über dieses erfolgreiche Verfahren hinaus arbeiten wir an weiteren Möglichkeiten zur Effizienzsteigerung, beispielsweise durch synthetische Trainingsdaten, automatisierte Vor-Annotierungen, Kombinationen aus Netzen und Heuristiken sowie der Erstellung von allgemeinen Datensätzen, die einen Grundstock bilden und auf Projekte eines Themas mit nur leichten Modifikationen angewendet werden können.