Vom 3D-Modell zu simulierten Messdaten: Netze trainieren im virtuellen Raum

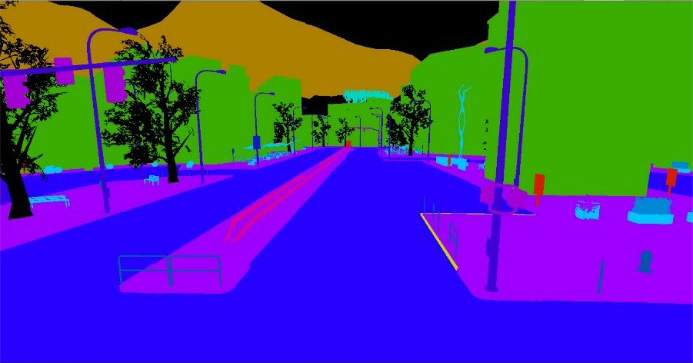

Grundlage synthetischer Trainingsdaten ist ein dreidimensionaler Datensatz, der eine virtuelle Repräsentation der Umgebung, z. B. einer typischen Stadtszene, bildet (Abb. 1). Aus dieser eigens erzeugten digitalen 3D-Modellwelt kann einerseits eine fotorealistische Darstellung erzeugt werden (Abb. 2), die eine reale Kameraaufnahme simuliert und dabei virtuell die Parameter real existierender Messgeräte simuliert. Andererseits kann vollautomatisiert eine Segmentierung des 3D-Modells generiert werden, in der jedem Pixel des Kamerabilds eine Objektklasse zugeordnet wird (Abb. 3). Da sich eine Szene aus zuvor selbst festgelegten und somit bekannten Objekten zusammensetzt, ist die Segmentierung der Daten inhärent gegeben. Die bislang händische Zuordnung wird damit obsolet. Aus einem 3D-Modell lassen sich also sowohl die Messdaten, beispielsweise Kamerabilder, als auch segmentierte Bilder – die Trainingsdaten – mit 100-prozentiger Genauigkeit erstellen, während der manuelle Prozess immer fehlerbehaftet ist. Das synthetische Erstellen der Trainingsdaten ist demnach nicht nur effizienter, sondern auch genauer als das manuelle Annotieren von Daten. Zudem können die Trainingsdaten aus verschiedenen, frei wählbaren Perspektiven im Raum erzeugt werden. Aus einem Datensatz können also diverse Anwendungen mit unterschiedlichen Aufnahmeperspektiven – etwa aus der Luft, von der Straße oder dem Gehsteig – bedient werden.

Tiefes Verständnis der Prozesskette ist der Schlüssel

Beim Rendern der jeweiligen Szene nutzen wir unser umfassendes Know-how in den Bereichen Modellierung und Messtechnik: Neben der reinen 3D-Geometrie spielen die Materialeigenschaften der Oberflächen, die Beleuchtungssituation sowie – im Außenbereich – Wetterverhältnisse und je nach Anwendungsfall weitere Eigenschaften eine Rolle. Hinzukommen mitunter dynamische Eigenschaften wie die Bewegung von Objekten in der 3D-Szene. Für eine zuverlässige und effiziente Datenauswertung muss darüber hinaus das in der späteren Anwendung eingesetzte Messsystem berücksichtigt werden. Am Ende sollen aus den 3D-Modellen mit sämtlichen Zusatzinformationen realitätsnahe, virtuelle Messdaten für verschiedene Messgeräte erzeugt werden.

Mit mobilen Mapping-Systemen erzeugte Messdaten liegen vor allem als 3D-Punktwolken, 2D-Kamerabilder oder 360°-Panorama-Aufnahmen vor. Die Messdaten entstehen mithilfe von Laserscannern und Kameras. Bei der Modellierung gilt es nun, die gerätespezifischen Charakteristika nachzustellen: Wie interagiert das Messsystem mit der Umgebung? Dafür ist es nötig, sowohl die Interaktion der Lichtpulse mit dem jeweiligen Oberflächenmaterial (Sonnenlicht, Umgebungslicht, künstliche Beleuchtung, Laserstrahl) als auch die Vorgänge im jeweiligen Messgerät (Scanner, Kamera) in ausreichender Tiefe algorithmisch nachzubilden.

Für eine möglichst hohe Effizienz bei der Entwicklung und Anwendung von Software für das Training von KNN muss sorgfältig zwischen physikalisch möglichst exakter Nachbildung und einer ausreichenden, auf Heuristiken beruhenden Näherung der jeweiligen Phänomene abgewogen werden. Dies erfordert umfangreiche Kenntnis des jeweiligen Aufnahmeprozesses und des Stands der Wissenschaft in der algorithmischen Nachbildung solcher Prozesse. Fraunhofer IPM hält eine Bibliothek von Algorithmen vor, die es erlauben, aus einem Baukastensystem von generischen 3D-Modell-Komponenten durch Parametrisierung eine Vielzahl von 3D-Szenen mit unterschiedlichen Eigenschaften zu erzeugen.